Багато блогерів шукають відповідь на таке питання: "Як позбутися від дублів сторінок?", Для того, щоб видалити дублі сторінок свого сайту з результатів видачі пошукових систем. Дубльовані сторінки потрапляють в індекс пошукових систем, де вони присутні поряд з основною просуває сторінкою.

Таких сторінок може бути дуже багато, при цьому, пошукова система повинна буде ранжувати однакові сторінки в пошуковій видачі. За це пошукова система може накласти санкції на основній сторінці, знижуючи її в пошуковій видачі. Таким чином, дублі сторінок мають шкідливий вплив на просування сторінок сайту в пошуковій системі.

зміст:- Моя історія боротьби з дублями сторінок

- Пошук дублів сторінок

- Заборона на індексацію в файлі robots.txt

- Додавання параметра replytocom в інструменти для веб-майстрів

- Плагін WordPress Thread Comment для деревовидних коментарів

- Плагін WordPress SEO by Yoast для видалення replytocom

- 301 редирект для видалення replytocom

- Налаштування SEO плагіна

- Видалення дублів сторінок вручну

- Як видаляються дублі на моєму сайті

- Ще один спосіб для боротьби з дублями сторінок

- висновки статті

Дубльовані сторінки можуть копіювати повний зміст, або тільки часткове утримання головної сторінки. Зокрема, CMS WordPress сама створює, в деяких випадках, дубльовані сторінки, наприклад, всім відомий "replytocom" (коментар, відповідь на коментар, репліка).

Якщо на вашому сайті включені деревовидні коментарі, то в цьому випадку, кожен коментар буде створювати дубль сторінки. Тому, якщо дублі сторінок сайту присутні в індексі пошукових систем, то тоді необхідно буде видалити такі сторінки з результату видачі пошукових систем.

Наявність дубльованих сторінок в пошуку, шкодить сайту при його просуванні в пошукових системах. Пошукові системи знижують позиції сайту, зменшується так званий вага сторінки, погіршується індексація сайту і т. П.Пошукова система Google звертає особливу увагу на наявність дублів сторінок, знижуючи позиції сайту при наявності великої їх кількості. Я не буду більше теоретизувати на цю тему, а краще розповім вам про те, як я борюся з дублями сторінок, на прикладі свого сайту - vellisa.ru.

Моя історія боротьби з дублями сторінок

На самому початку весни 2013 року моєму сайту виповнився рік, в цей час відвідуваність сайту становила приблизно 2000 відвідувачів на добу. Потім відвідуваність на сайті почала різко падати. Уже в середині травня відвідуваність ледь перевищувала 1000 відвідувачів в добу.

Навесні 2013 року у багатьох блогерів, в зв'язку з введенням нових алгоритмів, знизилася відвідуваність з Гугла. На моєму сайті відвідуваність з пошукача Google зменшилася приблизно на 40%. У моєму випадку, на спад відвідуваності вплинув введення нових алгоритмів, а також деякі зміни, які я зробив в той час на своєму сайті.

Подумавши, я вирішив повернути колишню відвідуваність для свого сайту. За літо я виконав це завдання, у вересні моєму сайту вдалося знову вийти на середню відвідуваність у 2000 відвідувачів на добу. Далі відвідуваність мого сайту продовжила збільшуватися.

Начебто все добре, але справа в тому, що зростання відвідуваності стався, в основному, за рахунок пошукової системи Яндекс. Якщо раніше співвідношення відвідувачів прийшли на сайт з пошуку Яндекса і Google, було 3 до 1 (зразкове співвідношення, грубо) на користь Яндекса, що приблизно відповідає частці пошукових систем в Рунеті, то потім таке співвідношення зросло до 5 до 1. З'явилася сильна залежність від однієї пошукової системи.

Відвідуваність з Гугла росла дуже повільно, тільки навесні 2014 року вона досягла рівня минулого року. А адже в цей час, цілий рік, я писав нові статті. Виходить, що Яндекс адекватно реагував на додавання нових статей на сайті, чого не скажеш про Google.

У грудні 2013 роки мені довелося встановити на свій сайт новий шаблон, так як на попередньої теми, у мене не виходило змінити структуру свого сайту. Ці дії мені необхідно було зробити в будь-якому випадку.

Після цього я звернув увагу на дубльовані сторінки в індексі пошукових систем. До цього я знав про цю проблему, читав про способи її вирішення, але поки нічого не робив.

Я, в будь-якому випадку, не став би відключати на своєму сайті деревовидні коментарі, тому що через це буде незручно відвідувачам сайту, а також я не хотів використовувати плагіни для видалення дублів сторінок.

У підсумку, в файл htaccess був встановлений код, а з файлу robots.txt були видалені деякі директиви (докладніше, що я робив, розповім нижче). Поступово, в результатах видачі пошукових систем зменшилася кількість дубльованих сторінок мого сайту.

У березні 2014 роки я додав параметр "replytocom" в інструменти для веб-майстрів Google, а в травні я додав туди ще один параметр: "feed".

На даний момент, на моєму сайті не залишилося дублів сторінок в результатах видачі пошукової системи Google, які мають в своєму адресу змінну replytocom, але ж раніше таких сторінок там була величезна кількість (кілька тисяч).

Нарешті, я був приємно здивований зрослої, приблизно в 2 рази відвідуваністю з Гугла. Тепер співвідношення між пошуковими системами стало близько 2 до 1 на користь Яндекса.

Таким чином, на власному досвіді, я дізнався про те, як може вплинути на просування сайту, наявність дублів сторінок в індексі пошукової системи.

Правда, тут необхідно буде враховувати, що пошукові системи ранжирують сторінки в результатах видачі по багатьом параметрам. Тому у вас, можливо, не відбудеться значне зростання відвідуваності вашого сайту. У будь-якому випадку, видалення дублів сторінок з результатів пошукової видачі, позначиться сприятливо на вашому сайті.

Пошук дублів сторінок

Для пошуку дублів сторінок на своєму сайті, введіть в пошуковий рядок такий вислів - "site: vellisa.ru" (замість "vellisa.ru" введіть назву свого сайту). Перейдіть на останню сторінку пошукової видачі, у мене, в даному випадку, це 19 сторінка. Запам'ятайте номер цієї сторінки, щоб потім ви могли швидко перейти до цієї сторінки.

На останній сторінці пошукової видачі, нижче останнього результату видачі, ви побачите оголошення, в якому вам повідомляють, що пошукова система приховала деякі результати, які дуже схожі на вже представлені вище. Далі натисніть на посилання "Показати приховані результати".

Після цього знову буде відкрита перша сторінка пошукової видачі. Відразу переходьте до тієї сторінці, яку ви запам'ятали, в моєму випадку, це 19 сторінка. На цій, або на наступній сторінці, ви побачите дубльовані сторінки свого сайту.

На цьому зображенні видно такі дубльовані сторінки, які мають в URL посилання "feed" і "tag". Також в результатах пошукової видачі можуть бути присутніми дублі з "replytocom", "page" і з деякими іншими параметрами.

Інший великою проблемою, якщо на сайті використовуються деревовидні коментарі, є наявність величезної кількості сторінок зі змінною replytocom, які генерує сама CMS WordPress.

Перевірити наявність сторінок з replytocom можна таким чином: введіть в пошуковий рядок Google вираз - "site: vellisa.ru replytocom" (без лапок). Замість "vellisa.ru" вставте назву свого сайту.

На моєму сайті дубльованих сторінок з replytocom немає, незважаючи на те, що на моєму сайті присутні деревовидні коментарі. Для прикладу я візьму сайт однієї моєї подруги Юлії (inet-boom.ru), сподіваюся, що вона за це на мене не образиться.

На цьому зображенні, в самому кінці посилання, після адреси сторінки, ви побачите таке закінчення посилання - "? Replytocom = 3734". Цифри в кінці адреси будуть змінюватися в залежності від номера коментаря.

Таких сторінок в індексі пошукової системи може бути величезна кількість. Тому з дублями replytocom потрібно буде боротися.

Що необхідно буде зробити?

- Перевірити наявність дубльованих сторінок в індексі пошукових систем.

- Закрити необхідні параметри від індексації у файлі robots.txt.

- Додати необхідні параметри в панель для веб-майстрів Google.

Ці вимоги треба буде виконати в обов'язковому порядку. Решта дії будуть залежати від того способу, який ви оберете для боротьби з дублями сторінок.

Вам потрібно буде додати свій сайт в інструменти для веб-майстрів Google і Яндекса, для того, щоб вирішувати проблему позбавлення від дублів сторінок за допомогою цих інструментів пошукових систем.

Заборона на індексацію в файлі robots.txt

Для заборони на індексацію певних параметрів, які впливають на появу дубльованих сторінок в пошуку, вносяться директиви в файл robots.txt. При використанні директиви Disallow дається команда пошуковим роботам для заборони індексування.

Команди на заборону індексації у файлі robots.txt можуть виглядати приблизно так (на цьому прикладі частина файлу):

Директиви зі знаком питання (?) Зазвичай присутні, якщо на сайті створені так звані ЧПУ посилання, за допомогою яких змінюється URL веб-сторінки. Тут також присутній команда на заборону на індексацію посилань зі змінною replytocom.

Якщо пошукова система Яндекс, в цілому, виконує директиви, внесені в файл robots.txt, то з пошуковою системою Google все набагато складніше. Роботи Гугла індексують всі, незважаючи на заборони, прописані у файлі robots.txt.

В плагінах для SEO оптимізації присутня можливість закриття тегом "noindex" рубрик, міток, архівів, сторінок пошуку і т. Д. Правда, не завжди ці вказівки виконуються пошуковими роботами.

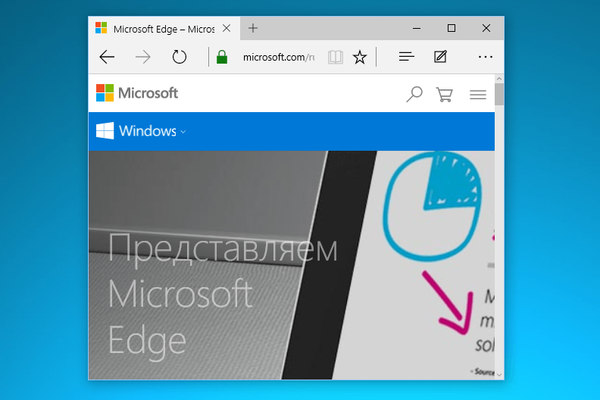

Додавання параметра replytocom в інструменти для веб-майстрів

В Google webmaster tool увійдіть на сторінку "Інструменти для веб-майстрів". У правій колонці "Панель інструментів сайту", спочатку натисніть на кнопку "Сканування", а потім натисніть на кнопку "Параметри URL".

На цій сторінці ви можете додати нові параметри або змінити вже додані, для обробки пошуковими роботами Google. Залежно від налаштувань, пошуковий робот Googlebot ігноруватиме певні параметри при внесенні сторінок сайту в індекс пошукової системи.

- Для додавання нового параметра натисніть на кнопку "Додавання параметра".

- Після цього відкривається вікно "Додавання параметра".

- В поле параметр (з урахуванням регістру) додаєте новий параметр, в даному випадку "replytocom".

- На питання: "Чи змінює цей параметр зміст сторінки, які бачить користувач?", Відповідаєте: "Так, параметр змінює або реорганізує або обмежує зміст сторінки".

- При відповіді на питання: "Як цей параметр впливає на зміст сторінки?", Вибираєте варіант відповіді: "Інше".

- На питання: "Які URL, що містять цей параметр, повинен сканувати робот Googlebot", відповідаєте: "Ніякі URL".

- Потім натискаєте на кнопку "Зберегти".

Подібним чином ви можете додати і інші параметри. Якщо параметр вже є у списку, то для зміни його налаштувань необхідно буде натиснути на посилання "Змінити".

Після додавання параметра replytocom в панель для веб-майстрів, з файлу robots.txt потрібно видалити приблизно таку директиву "Disallow: / *? Replytocom" (якщо вона присутня в файлі Роботс) для того, щоб googlebot переходив по посиланнях з цим параметром, і видаляв їх з індексу.

Якщо на вашому сайті немає дублів сторінок з таким параметром, то тоді вам можна буде залишити таку директиву в файлі robots.txt.

Поступово дубльовані сторінки будуть видалятися з індексу пошукової системи. Якщо дубльованих сторінок дуже багато, то в цьому випадку, процес видалення дублів сторінок буде відбуватися досить тривалий час, можливо навіть, протягом декількох місяців.Плагін WordPress Thread Comment для деревовидних коментарів

Так як, появі replytocom сприяють деревовидні коментарі, то деякі користувачі взагалі відключають їх на своєму сайті. Після відключення деревовидних коментарів, особливо, якщо статті на сайті активно коментуються, виходить дуже незручна навігація. Відвідувачу, часом взагалі незрозуміло, хто, де, кому, що відповів.

Плагін WordPress Thread Comment вирішує проблему деревовидних коментарів в WordPress. Деревовидні коментарі залишаються на сайті, при цьому змінні replytocom не повинні додаватися. Плагін виводить посилання з коментарю через javascript, тому пошукові роботи не індексують це посилання.

Нові змінні replytocom з'являтися в індексі пошуковика вже не будуть, а старі змінні доведеться поступово видалити з індексу пошукової системи.

Мені особисто в цьому плагіні не сподобався зовнішній вигляд коментарів. Я не став використовувати цей плагін на своєму сайті. Зауважу, що плагін WordPress Thread Comment для боротьби з replytocom, рекомендував використовувати Олександр Борисов.

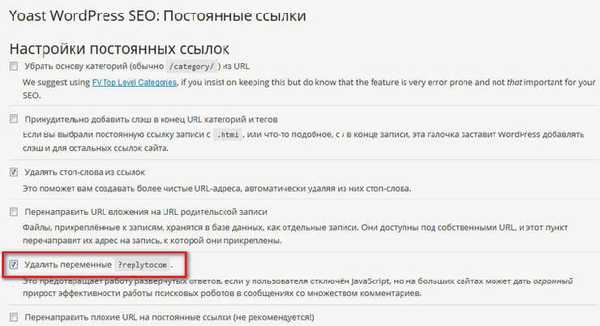

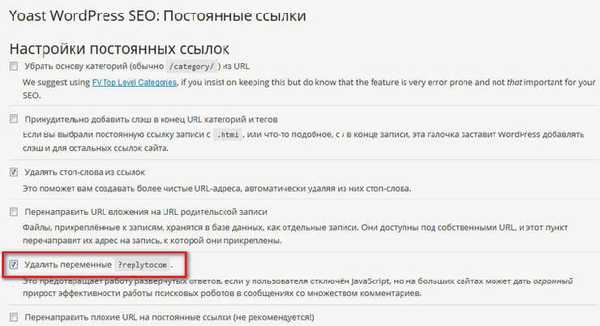

Плагін WordPress SEO by Yoast для видалення replytocom

Плагін WordPress SEO by Yoast, досить потужний плагін для SEO оптимізації сайту, окрім усього іншого, дозволяє видалити з сайту змінні replytocom. При цьому, деревовидні коментарі залишаться на вашому сайті.

Після установки плагіна WordPress SEO by Yoast на свій сайт, в настройках плагіна, в розділі "Постійні посилання", необхідно буде активувати пункт "Видалити змінні? Replytocom".

Після цього, поступово дубльовані сторінки з "соплями" replytocom будуть видалятися з індексу Google.

Так як, на моєму сайті встановлений плагін All in One SEO Pack, і з деяких причин, я поки не хочу переходити на плагін WordPress SEO by Yoast, то я не став використовувати цей варіант, для боротьби з дублями сторінок.

301 редирект для видалення replytocom

Це, напевно, самий радикальний спосіб боротьби з replytocom. Я використовував саме цей метод.

Після зміни шаблону, Лариса Web-Кішка запропонувала мені використовувати 301 редирект для боротьби з дублями replytocom. До зміни шаблону на сайті, я не наважувався використовувати цей метод.

Тепер я можу сказати, що при використанні 301 редиректу, а також після деяких дій, про які я напишу нижче, мій сайт успішно впорався з дублями replytocom.

На цьому зображенні ви можете побачити, що на моєму сайті немає дубльованих сторінок зі змінною replytocom, незважаючи на те, що на моєму сайті присутні деревовидні коментарі, без використання спеціальних плагінів.

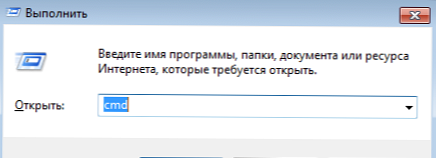

Для використання 301 редіректу потрібно вставити спеціальний код в файл "htaccess", який знаходиться в кореневій папці вашого сайту. Коренева папка сайту - це та папка вашого сайту, в якій знаходяться папки "wp-admin", "wp-content", "wp-includes" і т. Д.

У файл htaccess, нижче рядка "RewriteBase /", необхідно буде вставити такий код:

RewriteCond% QUERY_STRING replytocom = RewriteRule ^ (. *) $ / $ 1? [R = 301, L]Увага! До початку вставки цього коду оригінальний файл htaccess на своєму комп'ютері. Якщо ви зробите помилку, що щось піде не так, то тоді ви зможете замінити модифікований файл htaccess на оригінальний файл, використовуючи для цього файловий менеджер на своєму хостингу, або через FTP за допомогою програми FileZilla.

При виникла пов'язаних із ними, замість свого сайту ви можете побачити "білий екран смерті". Заміна модифікованого файлу на оригінальний файл htaccess, поверне працездатність вашого сайту.

Після вставки коду потрібно буде перевірити роботу 301 редиректу. Для цього, спочатку необхідно буде вставити в адресний рядок браузера посилання, що містить replytocom, а потім перевірити результат переходу. Після переходу, посилання на відкритій веб-сторінці повинна буде змінитися на оригінальне посилання, що не містить в URL змінної replytocom.

Далі необхідно буде зробити ще дві речі. Спочатку потрібно буде видалити з файлу robots.txt директиви, що містять заборону на індексацію сторінок зі знаком питання. Директиви видаляються в тому випадку, якщо ви будете використовувати цей метод.

Потім необхідно буде додати параметр replytocom в "Інструменти для веб-майстрів Google", як це зробити я написав вище в статті.

Налаштування SEO плагіна

Для запобігання індексації сторінок архівів, рубрик, міток, 404 сторінок, сторінок пошуку, пагінацію (посторінковою навігації), в плагін All in One SEO Pack необхідно буде активувати пункти для додавання аргументів noindex, follow і noindex, nofollow (для посторінкового навігації).

В плагіні WordPress SEO by Yoast параметри індексування для пошукових роботів будуть виглядати таким чином: noindex, follow.

Тепер, вам буде потрібно запастися терпінням, і почекати коли Гугл видалить дубльовані сторінки зі свого індексу. Якщо ви не хочете довго чекати, або якщо на вашому сайті залишилося зовсім небагато дубльованих сторінок, то тоді ви можете прискорити їх видалення.

Видалення дублів сторінок вручну

Ви можете вручну додати посилання на дублі сторінок в "Інструменти для веб-майстрів" для їх видалення з індексу пошукової системи. Коли на моєму сайті, у видачі пошукової системи, залишилося не так багато дубльованих сторінок, я також вручну додав знайдені результати, для більш швидкого їх видалення з індексу.

- На сторінці "Інструменти для веб-майстрів", в правій колонці "Панель інструментів сайту", спочатку натисніть на кнопку "Індекс Google", а потім натисніть на кнопку "Видалити URL-адреси".

- Далі буде відкрита сторінка "Видалити URL-адреси". На цій сторінці потрібно буде натиснути на кнопку "Створити новий запит на видалення".

- Під кнопкою відкриється поле, в яке слід вставити посилання. Після цього потрібно буде натиснути на кнопку "Продовжити".

- Далі відкриється нова сторінка, на якій буде відображено видаляється URL. У пункті "Причина" виберіть такий варіант: "Видалити сторінку з результатів пошуку та з кеша". Потім натисніть на кнопку "Відправити запит".

- На сторінці "Видалити URL-адреси" ви побачите додані посилання, які чекають черги на видалення. Точно таким способом, ви можете додати наступне посилання для її видалення з результатів пошуку та з кеша пошукової системи Гугл.

Проблема існує, вона може чинити негативний вплив на просування сайту, тому адміністратору сайту потрібно буде позбутися від дублів сторінок для отримання позитивного результату.

Пройшов місяць з дня опублікування цієї статті, тепер настав час доповнити публікацію нової інформацією.

Як видаляються дублі на моєму сайті

Зараз я розповім, як саме, в даний момент, здійснюється боротьба з дублями сторінок на моєму сайті.

- Я видалив з файлу robots.txt деякі забороняють директиви, для того, щоб відкрити доступ пошуковим роботам до певних тек мого сайту.

- В плагіні для СЕО оптимізації (AIOSP), мною були відзначені пункти для додавання мета тега Роботс для відповідних сторінок сайту. Пошуковий робот переходячи на таку сторінку побачить забороняє метатег і не буде індексувати дану сторінку.

Для цього було відкрито доступ до певних сторінок у файлі robots, для того, щоб робот перейшов на дану сторінку, і побачив такі метатеги:

meta name = "robots" content = "noindex, nofollow" meta name = "robots" content = "noindex, follow"

Тому пошуковий робот не буде індексувати сторінку з такими метатегами. Раніше потрапили в індекс сторінки, будуть поступово вилучені з видачі пошукових систем.

- Були додані параметри replytocom в панель веб-майстра Google.

- Мною був доданий наступний код в файл htaccess:

RewriteCond% QUERY_STRING replytocom = RewriteRule ^ (. *) $ / $ 1? [R = 301, L] RewriteRule (. +) / Feed / $ 1 [R = 301, L] RewriteRule (. +) / Comment-page / $ 1 [R = 301, L] RewriteRule (. +) / Trackback / $ 1 [R = 301, L] RewriteRule (. +) / comments / $ 1 [R = 301, L] RewriteRule (. +) / attachment / $ 1 [R = 301, L] RewriteCond% QUERY_STRING ^ attachment_id = [NC] RewriteRule (. *) $ 1? [R = 301, L]

В цей код увійшли 301 редирект з replytocom, а також редіректи з іншими параметрами, які я взяв з сайту Олександра Борисова. Як я зрозумів, автором редиректів для інших параметрів є відомий блогер Олександр Алаев (Алаіч').

З файлу robots.txt були видалені відповідні директиви (feed, comments, trackback та т. П.) Для параметрів, які були додані в файл htaccess.

Після цього, пошуковий робот переходячи на дубльовану сторінку, яка має в URL адресу такі параметри, буде перенаправлений за допомогою 301 редіректу на оригінальну сторінку мого сайту.

- У файл functions.php був доданий код для запобігання появи нових дублів з replytocom, який знайшов в інтернеті відвідувач мого сайту, Антон Лапшин:

function replace_reply_to_com ($ link) return preg_replace ( '/href=\'(.*(\?|&)replytocom=(\d+)#respond)/', 'href = \' # comment- $ 3 ', $ link ); add_filter ( 'comment_reply_link', 'replace_reply_to_com');

Цей код потрібно буде вставити в файл "Функції теми" (functions.php) перед закриває тегом?>.

Після вставки коду, при наведенні курсору миші на кнопку "Відповісти" в коментарях, на засланні, яка буде видна в лівому нижньому кутку вікна браузера, тепер не буде з'являтися змінна replytocom. Отже, нові посилання з цим параметром не будуть додаватися в індекс пошукових систем.

Перед внесенням змін, не забудьте зробити резервну копію файлу "Функції теми".

Всі ці настройки працюють, в основному, для пошукової системи Google. В Яндекс співвідношення кількості завантажених роботом сторінок і сторінок в пошуку на моєму сайті, на даний момент, оптимальне.

Ще один спосіб для боротьби з дублями сторінок

Я знайшов в інтернеті ще один спосіб для видалення дублів сторінок з пошукової видачі. За допомогою коду на певні сторінки сайту буде додано мета тег Роботс noindex, nofollow для заборони індексації таких сторінок.

Даний код вставляється в файл functions.php відразу за

function meta_robots () if (is_archive () or is_category () or is_feed () or is_author () or is_date () or is_day () or is_month () or is_year () or is_tag () or is_tax () or is_attachment () or is_paged () or is_search ()) echo "". ''. "\ n"; Add_action ( 'wp_head', 'meta_robots');

Після додавання цього коду, в плагіні для SEO оптимізації необхідно буде відключити додавання мета тега Роботс до даних сторінок. В плагіні All in One SEO Pack - розділ "настройки індексування (noindex)".

Потім необхідно буде прибрати з файлу Роботс відповідні заборонні директиви.

Таким способом можна буде закрити від індексації необхідні сторінку. Тільки для позбавлення від дублів replytocom необхідно буде використовувати один з методів, які описані в цій статті. Крім використання редиректу і плагінів, також ще можна буде укласти посилання з коментарів в тег span, для того, щоб вони не індексувалися пошуковими системами.

Після завершення налаштувань, вам потрібно буде, час від часу, стежити за процесом видалення дублів сторінок з вашого сайту.

висновки статті

Вебмастеру слід звернути увагу на наявність дублів сторінок сайту, і в разі їх виявлення, вжити заходів щодо їх видалення з пошукової видачі, тому що вони негативно впливають на просування сайту. Через це, сайт може потрапити під санкції пошукових систем.

Схожі публікації:- Як перевести сайт на HTTPS

- Як збільшити відвідуваність сайту

- Як встановити рекламу на сайті

- Огляд швидкого хостингу AdminVPS

- Плагін Breadcrumb NavXT - хлібні крихти для сайту